crustgroup(он же Already Yet)

11 октября 2013

В английском языке есть интересная грамматическая коллизия: в третьем лице единственного числа все существительные могут заменяться, в зависимости от значения, на «он» (he), «она» (she) или же безликое «оно» (it). При этом не имеет значения, о ком мы говорим — о быке или о корове, о волке или о волчице — даже в случае животных мы всегда будем ставить в предложении бесполое и безликое личное местоимение it.

А вот в случае разговора о людях или же в случае совсем уж персонифицированного рассказа о животных, надо обязательно употреблять местоимения he и she.

Ну а какое-нибудь здание или автомобиль — так они и вообще всегда it.

Но есть в английском языке и интересные исключения из правил.

Она несёт нас по волнам, она защищает нас от бури своими деревянными стенами. И никак иначе.

Те же коллизии есть и у Айзека Азимова в его длинном сборнике рассказов под общим названием «Я, робот».

Роботы, начав свой поход вперёд от безликого «оно», на протяжении связанных во времени рассказов, всё больше и больше обретают своё особенное «я», в конце цикла превращаясь в практически идентичные копии людей.

Когда-то считалось, что показателем «разумности» робота будет его возможность обыграть человека в шахматы. В принципе, это уже давно свершилось. В итоге людям, для оправдания уникальности своей роли в наблюдаемой Вселенной, пришлось сосредоточиться на таких гораздо менее осязаемых вещах, как «симфония» или «шедевр».

Вопрос, заданный героем Уилла Смита роботу в экранизации произведения Айзека Азимова звучал именно так. Но непрозвучавший ответ робота Санни мог вполне выглядеть и вот так. Нецензурно, зато по делу.

Но что может сулить нам такое будущее? Будущее, в котором робот всё-таки сможет написать симфонию или создать шедевр? Ладно, чёрт с ним! Убрать мусор в доме и отвести ребёнка в школу. Ну и преподать ему физику и основы информатики — чем чёрт не шутит? Как будет выглядеть такой мир?

Робот-я, робот-оно. Поехали.

Во-первых, стоит отделить наши иррациональные страхи от реальности нашего мира.

Вероятнее всего, что разумные роботы, созданные людьми, будут столь же моральны или аморальны, как и их создатели.

Сам Айзек Азимов для обхода такой ситуации создал гипотетическую этику «трёх законов робототехники», которые якобы должны были якобы позволить привить роботам человеческую мораль и этику.

Однако, на деле, весь его цикл рассказов от самого первого «Хоровода» и вплоть до предсмертного романа «Роботы и Империя», который прокинул мостик от цикла о роботах до цикла об Основании, повествовал как раз о том, как роботы изящно попадали в ловушки трёх законов, пытались их разрешить, бессознательно или сознательно старались обойти — а то и впрямую нарушить.

Всё дело в том, что само по себе определение Первого Закона, который сформулировал Азимов, оказалось весьма шатким и неопределённым: «Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред».

Для понимания разности формулировок, опуская Второй Закон, приведём тут сразу же формулировку Третьего Закона:

«Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму Законам».

Видите, в чём тут большая разность? Я специально не выделял здесь аналогичные слова, но внимательные читатели уже вполне могли понять, в чём разность законов.

Первый Закон сформулирован в категориях абстрактного «вреда», в то время, как Третий закон прямо говорит о конкретной «безопасности» робота.

Если же переформулировать ситуацию в виде постулатов теории игр, то Первый Закон задаёт роботу линию поведения в стратегии «минимального возможного проигрыша» для человека, в то время, как Третий Закон говорит лишь об «отсутствии немедленного, реального и окончательного проигрыша» для робота.

Условно говоря, робот в случае «размышлений» за человека должен учитывать все, даже самые далеко идущие последствия его или человека действий, в то время, как в случае «мыслей о себе» он лишь должен отсечь варианты, ведущие к непосредственному проигрышу.

Вам это ничего не напоминает?

«Сынуля, когда ты вырастешь, то я думаю, что тебе лучше поступить в хороший ВУЗ и найти себе достойную подругу в жизни»

«Папа? А что ты будешь делать в воскресенье?»

«Сын, я как-то пока ещё не думал об этом... Это важно?»

По сути дела, робот в случае полного соблюдения Трёх Законов вынуждается к игре в русскую игру «поддавки», которая во французском ёмко называется misère или мизер.

Именно этим и занимаются постоянно герои Азимова в цикле рассказов «Я, робот», постоянно ища приключений на свою задницу, попадая в передряги и опасные положения, из которых их и вытаскивают раз за разом умные, думающие и просчитывающие все варианты роботы.

Подобно тому, как взрослый человек следит за первыми шагами или самостоятельными действиями ребёнка, будучи всегда наготове либо подхватить его в нечаянном падении, либо строго сказать: «Брось, кака! Брось немедленно! Не в рот, только не в рот!»

Пусть они железные и непривычные — но они именно такие. Думающие за нас, решающие за нас, просчитывающие за нас.

Как это возможно? И что — это уже происходит сегодня, но мы это пока ещё не осознали толком?

Да, роботы уже это делают. И пусть это пока ещё не человекоподобные устройства, но форма, как мы помним, это отнюдь не главное. Содержание роботов уже обгоняет человеческое в значительной доле нашей повседневной жизни.

Люди всё больше и больше только общаются друг с другом, оставляя громадный пласт земной жизни за роботизированными системами.

Все вы, конечно, знаете вот такой простой момент, повсюду вошедший в нашу жизнь:

Для нас такое изображение — полная абракадабра. Наш собственный мозг в ходе долгой эволюции был ориентирован на восприятие совершенно иных образов. Вот таких:

Именно распознавание таких, биологических образов, лежало издревле в основе нашего социума. На верхнем фото вы легко отличите женщину от мужчины.

А понять, в какой стране произведен шоколадный батончик, просто посмотрев на штрих-код, слабо?

Да и не в штрих-коде уже передний край робототехники. Распознавание лиц сегодня — уже тоже рутинная и достаточно простая работа. Я думаю, многие читатели уже встречали такой движок в популярной программеPicasa:

В профиль вы или в анфас, грустите вы или смеётесь, накрашены вы или без косметики — роли не играет. Программа распознавания лиц «Пикасы» вытянет для вас ваш облик из любого снимка.

И не думайте, что «все азиаты на одно лицо». Вы просто не умеете читать их лицевой штрих-код. А для «Пикасы» это так — семечки.

Кроме того, если вы заметили, эта программа обучается вместе с вашими комментариями к фото. Посмотрев пару раз на ваши выборы «Пети Иванова», она быстренько находит вам ещё с десяток «Петь Ивановых» по тем же шаблонам, что засветились на вашем образцовом фото Пети.

То есть, по факту, вы просто программируете эвристики, а программа уже дальше использует их самостоятельно.

«Да ладно!» — скажете вы. «Программы тупые! Сколько я раз видел, как продавщица руками вводила штрих-код! И Люську Шевченко Пикаса-то на студенческих фотках так и не распознала!».

Да, ошибки бывают. Они смешные.

Но нет ли их и у людей?

Полно.

Говорят, что если ребёнок увидел на этой картинке тётеньку и дяденьку вместо десятка дельфинчиков — то мальчик уже вырос. Как в анекдоте о том, что «с этого момента писю называем членом и начинаем лечить сифилис».

Наше восприятие себя, как неких уникальностей, которые мыслят, чувствуют, страдают и радуются, и обладают некоей «свободой воли», которая как-то выгодно отличает нас от «тупо расписанной программы», весьма обманчиво.

На самом деле — мы такие же эвристические программы, которые были запрограммированы предыдущими поколениями ещё в раннем детстве. Как вы знаете, дети, попавшие к диким зверям, в итоге очень слабо от них отличаются — их обучающие механизмы внутри их головы были заточены на звериные навыки всё их детство, и, как следствие, во взрослом возрасте их способность к обучению полностью нарушена.

Но — насколько обучаем и насколько обладает свободой воли нормальный, взрослый человек?

Классический опыт Бенджамина Либета, проведенный ещё в седом 1979 году, показал нам чудовищную правду о нашей «свободе воли».

Опыт был проведен ещё до нейронаучной революции 1990-х годов, когда научились регистрировать тонкую деятельность мозга с помощью магнитного ядерного резонанса (так называемого ф-МРТ) — тогда Либету пришлось воспользоваться пациентами с вживлёнными в мозг электродами.

Уже в молодости Либет интересовался вопросом о возможности научного измерения процессов в сознании. Во второй половине 1950-х годов он решил экспериментировать с пациентами, которые находились под местным наркозом, в нейро-хирургическом отделении больницы в Сан-Франциско. Пациенты лежали там в операционном зале с частично открытым мозгом. Либет подключал провода к мозгу и раздрожал его слабыми электрическими импульсами. При этом он внимательно наблюдал, как и когда реагируют подопытные лица. Результат был ошеломляющий: от раздражения коры мозга до реакции пациента, выражавшейся в подергивании части тела, проходило более половины секунды. Однако тогда это парадоксальное поведение Либет не смог объяснить в полной мере — слишком грубым был опыт.

В 1979 году Либет пошёл дальше и соорудил простенький опыт, где испытуемый должен был подвигать правой или левой рукой на выбор и засечь по циферблату определённый момент времени, при этом активность мозга и действия испытуемого регистрировалась синхронизированными приборами. Сам циферблат часов тоже был необычный — он представлял собой бегущую в быстром темпе вокруг диска зеленую точку. Испытуемым Либет ставил одну и ту же задачу: «Смотрите на зеленую точку на часах. В определенный момент, который вы и только вы сами произвольно выберете, пошевелите кистью и запомните при этом положение зеленой точки.»

Затем Либет спрашивал испытуемых, где находилась зеленая точка, когда они приняли решение двинуть той или иной рукой, и записывал это.

Ну а приборы (электроэнцефалограф и датчик движения руки) писали то, когда это произошло на самом деле, исходя из их синхронизации с циферблатом.

И обнаружилось нечто невообразимое, за что исследователь и вписал себя в историю. Получалось, что мозг, судя по его активности, уже «принял решение», а человек лишь спустя короткий промежуток времени его воспроизводил.

Опыт проводили не единожды и результат был всегда един: сначала обнаруживалась работа мозга, потом спустя примерно полсекунды человек якобы «принимал решение». Экспериментаторы даже успешнопредугадывали еще не случившееся решение в случае многих испытуемых. Получалось, что то, что мы ощущаем как сознательное волевое решение («мотив, свобода воли») является уже лишь следствием («окончательным результатом») работы нашего мозга.

Наш мозг своими нижними, совершенно животными отделами, которые с нами ещё со времён крокодилов, принимает решение о действии примерно за полсекунды до того, как разум осознает этот выбор, как своё прямое волевое решение. Причем каждый раз человек искренне и уверенно считает, что всё, что происходит в опыте, он делает по собственному сознательному желанию. Но в виде этого «свободного волеизъявления» в сознании этот мотив проявляется примерно за 200 миллисекунд до реального действия.

Итого у сознания остается всего 100-150 мс на «право вето» — в последние 50 мс параллельно уже идет прямая активация соответствующих спинномозговых мотонейронов, которые уже и отвечают за действие руки. Этот опыт неоднократно переделывался, критиковался и вновь переделывался, и в общем и целом, со всеми оговорками — да, так и происходит.

Другими словами: не «Я» принимало решение, решение приняло наше «Оно» за 300 миллисекунд до того, как эту «красивую картинку» в её окончательном, готовом виде показали нашему «Я».

Поэтому «Я» обычно уже задним числом, получив такую «квитанцию», пытается осознать, что же произошло в крокодильем мозгу за 0,3 секунды до этого и что там уже пытаются делать мотонейроны параллельно с тем, что мы называем «свободой воли».

Именно так мы водим машины, танцуем, бегаем, ходим, взбиваем сливки, машем рукой своим любимым, вытираем сопли детишкам, закрываем замки входных дверей, печатаем текст комментариев в ЖЖ-шекче, чистим зубы или моем голову — и делаем ещё сотни и тысячи повседневных дел.

Этот эксперимент Либета многие ученые не принимали и всячески его критиковали, но спустя годы нечто схожее уже самостоятельно проделывали вновь — и вновь убеждались в изначальной правоте Либета. Вот такой вот, понимаешь, анимированный гиф живёт себе своей жизнью в нашем сознании. И исходя из действий наших глубинных, очень жёстко и чётко запрограммированных отделов и складывается всё наше «сознание». Ну — или 95% оного.

Всё-таки 100 миллисекунд у нас иногда есть.

Если что — на этом сюжете всё происходит где-то в 30 раз медленнее, чем ваш внутренний крокодил принимает решение за вас.

Причём, что интересно, глубокие отделы сами принимают решения, без участия и без спроса у нашего любимого сознания. Наш разум несет в этом смысле скорее обслуживающую функцию — какие-то решения ветирует, а вот остальные упаковывает в красивую и удобную обертку свободной воли и личного осознанного желания.

Впрочем, всё может оказаться и того хуже. Последние исследования по методикам Либета, но уже касающиеся более комплексных задач, нежели простые взмахи правой или левой руками и отметку точки на циферблате, проведенные уже с использованием самых последних технических приспособлений (в том числе и ф-МРТ), показали вообще невероятное:

«Был довольно долгий спор относительно того, насколько субъективное ощущение «волевого» решения определяется активностью мозга моментами ранее. Мы обнаружили, что результаты решения могут быть закодированы в мозговой активности префронтальной и теменной коры за 10 секунд до его воспринимаемого появления в сознании. Эта задержка, по-видимому, отражает работу сети областей высокоуровневого контроля , которые и начинают готовить предстоящее решение ещё задолго до его осознания.»

Поэтому: не смейтесь над роботами. Люди просто очень долго и очень комплексно программируются. Но суть ситуации та же — мы действуем во многом не сознательно, а шаблонно.

Не верите? Попробуйте почистить зубы другой рукой: не той, что вы чистите их каждое утро. Говорят, это очень сильно развивает мозг. Ну — или запишитесь на уроки танца.

Насколько же запрограммировано наше поведение в целом?

Очень сильно. Как это показал эксперимент Милгрэма. Мы очень редко думаем «своим умом». Мы опираемся на авторитеты, мы действуем шаблонно и очень часто не хотим расходовать на наш мозг ценнейшую глюкозу.

Эксперименты были и пострашнее. Настолько пострашнее, что и видео даже не осталось. Но есть фильм — пусть и художественный, но основанный на реальных событиях.

Если у вас есть достаточно времени — посмотрите оба фильма.

А потом вспомните три Закона Робототехники.

Вы поняли?

Они перевёрнутые от эгоистической, обыденной и привычной нам логики нашего сознания. Робот должен минимизировать «вред» другим и обеспечить лишь «безопасность» себе.

Люди же обычно хотят минимизировать «вред» себе, часто даже плюя на «безопасность» других.

«Выпустите меня, у меня больное сердце! Этот ток убивает меня!»

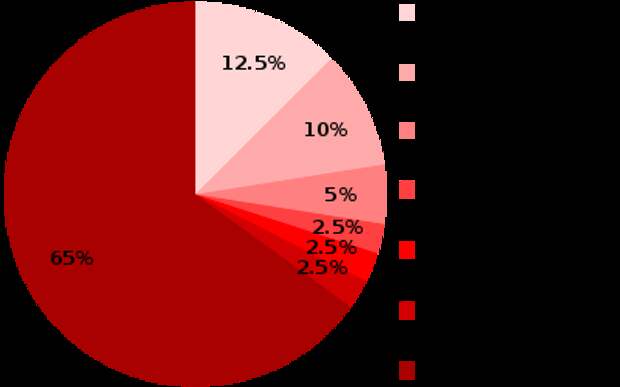

65% людей доходили в эксперименте Милгрэма до напряжения в 450 Вольт.

Вы всё ещё боитесь роботов? Они уже умнее нас. И, в общем-то, отнюдь не злее нас с вами.

Источник

Источник: forum.polismi.org.

|

Свежие комментарии